Problems

本文研究的问题是:在GAN的latent space上操作,使得Generator生成的图像的Memorability 对应地进行变化。Image Memorability:人的感觉上记住一张图像的可能性。

Paper Framework

整体的文章结构如下:

-

Introduction: 简要介绍了GAN, CNN可视化, 提高图像Memorability的方法。

-

GANalyze Framework

- Formula

- Implemtations

-

实验部分

- Model Validation: 验证模型是否可用。

- Emerging Factors: 分析Memorability影响的图像特点。

- Realness: 验证修改后生成的图像的真实性不受影响。

- Casual Effect: 人工测试验证Memorability是否真的提高。

-

讨论GANalyze的拓展,方法是替换Accessor模块。

本文在实验部分安排不够合理,在实验二中讨论了主观感受上Memorability修改的图像的特点,却直到实验四才实验验证了Memorability和这些修改特点的关联性。其次,实验三显得有些多余,BigGAN原文使用了truncate技术保证生成图像的质量,只要Transformer转化后的离原点不是太远,BigGAN可以保证生成的图像质量。还有将扩展部分并入到实验部分可能会更好。

Methods

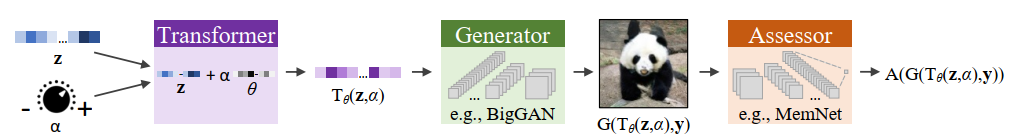

整体的模型由三部分组成:Transformer, Generator, Accessor,如图1所示。

Transformer,对进行变换:

Generator就是GAN的生成器,这里作者特指预训练好的class-conditional GAN的生成器:,其中是one-hot的标签向量。

Accessor对图像的某种感兴趣的属性进行判别,输出一个得分,通常是对某一种属性进行鉴别的预训练的网络。

整个模型的可学习参数是,它表征Transformer移动的方向。在这个架构的基础上,希望在某一个方向上,属性的得分可以随着的变化而变化,出现一种线性关系。则最佳方向:

实现中,作者选取BigGAN的Generator,选取MemNet作为Accessor,输入噪声且截断到,。

Conclusions

作者通过实验分析得到的结论有:

- latent space上变换大小和Accessor的平均得到存在线性关系。

- Memorability和一些的图像属性有关,且存在一定的线性关系,以下属性可以导致Memorability的提升:

- 中心物体更大

- 中心物体更接近图像中心

- 物体更偏向规则形状,如方形、圆形

- 中心物体数量减少,只有几个或者一个比较突出的物体

- 颜色更加鲜亮

- 在一定程度上修改后的图像同样比较真实

- 其他研究的属性:Aesthetic(美感)和景深、光照、调色板属性关系密切;

使得图像色彩更加丰富、散景(背景虚化)等可以提升emotional valence(情绪价)。 - 提高图像的Aesthetics会提升Memorability,但是影响很小,GANalyze方法对两种目标学习到的是不一样的,说明该方法可以学习不同属性的操作。

问题

- Image Memorability.

文章研究的是改变Image Memorability的属性,这里Memorability应该看成一种高级的复合语义。

但我觉得目前来说,研究Memorability这种高级复合语义可能不如研究低级的图像变化有意义,而且应用也没那么好。

推测作者本意就是研究Image Memorability的影响因素的,为了研究图像变化对高级语义的影响,先生成不同高级语义大小的图像,再对比寻找关联的图像的变化,而为了生成不同高级语义大小的图像,提出了GANalyze Framework。

- Limitation.

我认为没有探索该方法的边界(能力限度)是文章最大的缺陷之一。当继续增大或减小时,生成的图像肯定会出现失真,而保真的允许变换的区间范围作者并没有进行论述。

- EmoNet.

使用EmoNet作为Accessor的实际得到的图像的表现在感官上并不如AsetheticNet和MemNet,作者并没有进一步说明。作者对EmoNet的设计直接是ResNet50接一个全连接层输出,对于判断表情可能过于简单,所以推测EmoNet的模型设计是导致这一结果的原因。除此之外,文章使用在ImageNet预训练的BigGAN作为生成器,ImageNet许多类物体Emotional Valence属性并不强(比如非生物类),所以这一结果可能和数据集也有关。

- 线性关系

在分析过程中,作者仅仅取了5个变换比例分析线性关系,说服力不够强。

- 隐含内容

的公式隐含了假设:一种变换在latent space上的操作方向

与的取值无关。

对比

本文和"on the steerability of Generative Adversarial Networks"[1]一文研究的问题,使用的方法差不多,而且可能都是一个组的做的(MIT),二者具有可比性。

二者的相同之处:

- 本文的Transformer和[1]中的线性移动的方法一致。

- 假设隐含

二者隐含了相同的假设,而且都没有对该假设进行详细的论证。

二者的不同之处:

- 对移动后生成的图像的属性评价方法不一样}

这可以说是二者最大的不同之处。[1]使用自监督的方式,将生成的图像和原生成图像经过目标变换后的图像的L2距离作为评价的标准。本文直接使用一个预训练的网络对生成图像的某种属性进行评判。

- 研究的属性、问题稍有不同

本文研究控制Memorability, Asecthetic, Emotion这些高级的图像语义,部分工作是对这些高级图像语义解耦,寻找他们可对应的图像属性的变换。而[1]一文注重GAN可产生图像变换的效果,比如Zoom In, Zoom Out,Rotation等。

Reference

-

Ali Jahanian, Lucy Chai and Phillip Isola. On the “steerability” of generative adversarial networks. 2019

-

Shu Kong, Xiaohui Shen, Zhe Lin, Radomir Mech and Charless Fowlkes. Photo aesthetics ranking network with attributes and content adaptation. 2016

-

Goetschalckx, L., Andonian, A., Oliva, A., & Isola, P. (2019). GANalyze: Toward visual definitions of cognitive image properties. Proceedings of the IEEE International Conference on Computer Vision, 2019–October, 5743–5752. https://doi.org/10.1109/ICCV.2019.00584